使用云的一个方面是随时提供大量计算和存储资源。挑战在于管理和部署它们。这就是Kubernetes进入画面。

Kubernetes是一个用于自动化部署、扩展和管理容器化应用程序的开源系统。谷歌使用它运行数十亿容器每个星期,其他人都在做同样的事情。它使云资源的管理变得实用,即使是在一个小的管理团队中,因为重用配置要比单独配置系统容易得多。另一个优点是这些容器几乎可以在任何地方运行——这是因为云的底层结构在Kubernetes的编排中相对一致。

1.NVIDIA演示了Kubernetes在其gpgpu上的运行情况。

这使得NVIDIA的演示(图1)令人印象深刻的原因有两个。首先,它允许Kubernetes在管理cpu的同时管理GPGPU资源。GPU感知能够更有效地管理GPU应用程序,如机器学习(ML)应用程序的训练。

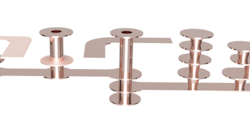

其次,用户可以利用NVIDIA的大规模GPGPU解决方案,如最新的DGX-2(图2).DGX-2采用NVIDIA的16端口NVLink开关芯片以及16个32gb特斯拉V100 gpgpu。gpgpu共享512gb HBM2内存空间。这个大型计算引擎将在Kubernetes的支持下部署在云计算中。

图1中的NVIDIA演示利用GPU计算资源,利用机器学习算法扫描花朵图片,识别图片中的花朵类型。这是一个通过添加相同应用程序的更多并行实例而具有良好伸缩性的应用程序。当然,演示从一个单一的GPU开始,随着更多带有GPU的系统上线,性能明显提高。

2.NVIDIA的DGX-2将16个32gb的特斯拉V100 gpgpu整合成一个使用NVSwitch芯片的单一GPU系统。

Kubernetes负责管理系统,很容易看出如何使用gpgpu扩展到数百个或更多的系统。然而,演示中最令人印象深刻的部分发生在删除一些系统并由云中的其他节点自动替换时。这种类型的负载均衡和弹性是Kubernetes解决方案的一部分,现在适用于gpu管理的容器和资源。

到目前为止,Amazon Web Services (AWS)和谷歌云平台(GCP)提供了这种支持gpu的Kubernetes。微软Azure认证正在进行中。

GPU支持是作为一个Kubernetes插件实现的。该插件使gpu成为一级资源,可以像管理其他系统资源一样进行管理。未来的增强包括GPU监控以及对不同GPU的支持。

这种支持对于云中的ML训练和推理应该是非常有用的。它可以在私有、公共或混合云以及大型嵌入式环境中工作。大型汽车和机器人模拟也可以从这种支持中受益。