今年虚拟GPU技术会议(GTC)的大新闻是Nvidia的释放A100(图1).具有542亿晶体管的A100可以达到400 W的最大热设计功率(TDP)的令人讨厌,并且可以使用内置的NVLINK连接大量模块。除了64 GB / S PCI Express(PCIe)Gen 4接口外,每个模块还支持600 GB / s的NVLINK带宽。PCIe界面支持SR-IOV。

A100基于该公司的新安培架构,与早期的V100 Volta和图灵架构相比,提供了显着的性能提升。包括为A100为40 GB的HBM2 ON模块存储器,内存带宽为1555 GB / s。还有一个40 MB L2缓存,几乎是V100的七倍。

A100包含7个GPU处理集群(GPCs)和7个纹理处理集群(TPCs),每个GPC包含16个流多处理器(SMs)(图2).十个512位内存控制器支持五个HBM2内存堆栈。SMS支持所有数据类型。基于新的共享内存的屏障单元提供异步障碍以处理新的副本说明。系统支持32个线程/翘曲和64个Warps / SM。

通常,多个a100被绑定到NVLink接口上,使得非常大的模型可以在一组芯片上运行。一个新的特性是多实例GPU (MIG),它允许相反的情况发生,将GPU资源分割成专用的和受保护的计算岛。最多可以定义7个实例来运行CUDA应用程序。CUDA 11是英伟达最新的编程环境。

每个MIG实例在整个内存系统中都有独立和隔离的路径。其他资源,如片内交叉端口、L2缓存库、内存控制器和DRAM地址总线也被分配给这些逻辑孤岛。这提供了可预测的吞吐量和延迟。L2缓存分配和DRAM利用率不会受到其他实例操作的影响。在每个实例中维护错误和故障隔离。

A100支持一系列数字格式,包括张量浮点32(图3).它提供了FP32的范围,但削减了有效位的数量,从而允许A100设计人员更有效地实现矩阵计算。该系统还支持FP16和BFLOAT16以及一系列整数格式。所有这些都是可用的,并对机器学习(ML)模型加速进行了优化。

64位浮点的峰值性能为9.7 Teraflops(TFLOPS)。在频谱的另一端是1248顶部的INT4性能。这些数字令人印象深刻,但NVIDIA的平台也实现了稀疏性优化。

ML和人工智能(AI)应用是A100的主要目标。ML / AI应用的神经网络模型通常利用稀疏矩阵操作。稀疏性支持允许更快地执行这些操作。对于张量浮动32,标准156 TFLOPS将312辆TFLOPS翻倍,具有稀疏性支持。除了整数支持之外,FP16和BFloat16还以类似的方式受益。

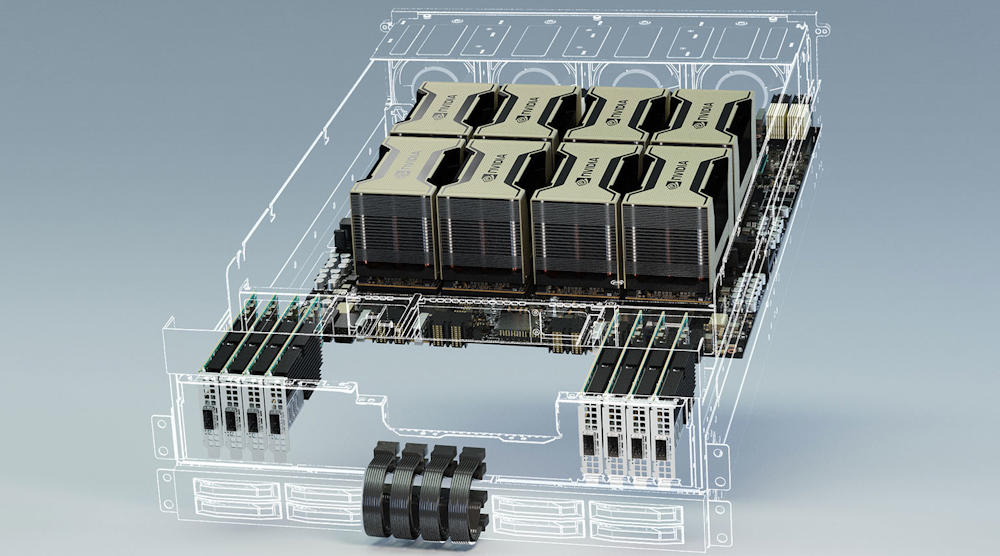

A100被用于许多形式因素,如DGX A100(图4).这个机器可以在一个机器上提供5千万亿次浮点运算的性能。DGX A100由8个A100模块、6个带宽为4.8 TB/s的nvswitch、9个Mellanox ConnectX-6 200gb /s接口卡、双64核AMD cpu和15tb的Gen 3 NVMe ssd盘组成,峰值带宽为250gb /s。它是基于HGX A100主板。

HGX A100主板寄宿八个A100模块,通过新的,更快的NVSwitch矩阵连接(图5).该平台还具有PCI Express开关,可支持200-GB以太网NIC,如Mellanox ConnectX-6以及NVME存储。一对高性能CPU可以连接到PCIe交换机。还提供四A100版本。都支持GPudirect Storage,它允许GPU与NVME存储一起使用,绕过CPU。

英伟达每隔几年就会按量级或量级推出更多的性能。单凭这一点就足以让人印象深刻,但真正让它发挥作用的是该公司围绕其硬件构建的软件基础设施。这从CUDA开始,包括从用于机器人的Isaac SDK到cuDNN,再到它对TensorFlow的支持。甚至新的米格战机支持也与Kubernetes集装箱管理系统集成在一起。