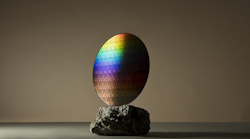

16-nmFinFET-based特斯拉P100(图1)下一代GPU是从哪来的英伟达.它针对一系列应用程序,包括深入学习,提供前一个GPU一代的12倍,NVIDIA的Maxwell架构。Tesla P100包括许多新功能和技术,包括高带宽存储器2(HBM2)和芯片上衬底上的基板(COWOS)技术。

特斯拉P100由153亿个晶体管组成。HBM2是下一代的堆叠片上存储器。AMD使用HBM在其最新Radeon R9系列.NVIDIA还为CPU和GPU添加了类似的统一内存支持amd's异构系统架构(HSA)。这允许CPU和GPU使用相同的指针结构,简化CPU和GPU程序。改进的内存系统提供了3倍内存带宽性能提升。TESLA P100 ECC内存以720 GBYTES / SEC运行。

深度学习技术采用数十到数千个层次的神经网络。特斯拉P100新的半精度指令允许它提供超过21 TFLOPS的峰值性能。它还提供5个双精度TFLOPS和10个单精度TFLOPS的性能。

特斯拉P100设计用于使用新的NVLink接口连接在一起的多芯片配置,运行速度为160gbytes /s,比PCI Express Gen 3快5倍。每个芯片有四个nvlink,允许矩形布局,而不需要额外的电路。

NVIDIA将八个Tesla P100 GPU放入新的DGX-1系统中(图2).紧凑的机架挂载系统还包括7tbytes的SSD存储和一对Intel Xeon cpu。每个GPU有16g的内存;所有这些都包含一个混合立方体网格。DGX-1有一对万兆以太网端口和一个四路100Gbit/s ib端口。3U系统仅使用3200瓦,售价12.9万美元。

在某些应用中,与cpu相比,特斯拉P100 GPU的性能有了显著提升。AMBER分子动力学代码就是一个这样的例子,其中一个Tesla P100具有与48个双插座CPU服务器节点相当的性能结果。AlexNet深度神经网络的培训可以由8个互联的特斯拉p100或250个双插槽CPU服务器节点来完成。

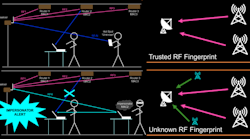

特斯拉P100和DGX-1由包含NVidia CUDA 8的新NVidia SDK支持。它可以利用在特斯拉P100上的HBM2和NVLinks。SDK还包括新的图形分析库nvGRAPH。这可以用于机器人路径规划、网络安全和物流分析等应用。

CUDNN图书馆版本5是GPU加速的深神经网络(DNN)库。它包括对用于数据的经常性神经网络,该数据用于包括顺序流(例如音频和视频)。CUDNN图书馆由领先的深度学习框架使用,包括谷歌的Tensorflow,UC Berkeley的Caffe,蒙特利尔大学的Theano和Nyu的火炬。

特斯拉的P100 gpu可以应用在汽车等许多应用领域。在2016年消费电子展(ces)上公布的Drive PX 2上,可以看到一对特斯拉P100 gpu。Drive px2提供了8个TLOPS的性能。

Drive PX 2是自动驾驶汽车的核心(图3)为了罗伯斯锦标赛.团队可以获得相同的硬件,然后用他们自己的软件定制,通常使用NVidia SDK这样的工具构建。这些汽车包括雷达、激光雷达、摄像机、GPS和高清地图支持等大量传感器。

Nvidia的Tesla P100代表了对先前的NVIDIA GPU的重大改进。它针对许多应用程序进行了优化,尤其是深度学习。它将在云和企业竞技中证明具有重新启动GPU计算的能力,允许系统支持多个用户。

寻找零件?去SourceESB.