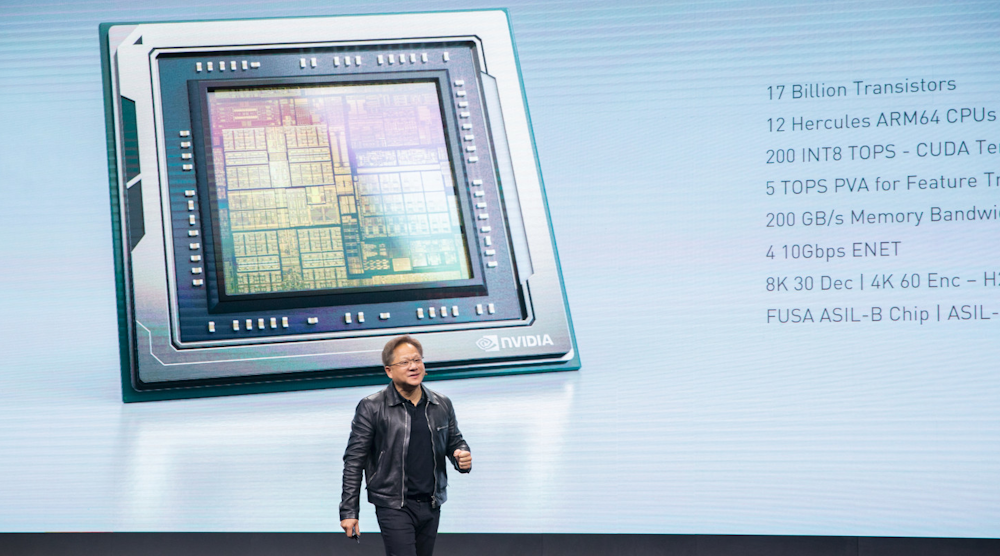

Nvidia的驱动AGX Orin SoC(图1)在Jetson AGX Xavier的基础上改进了7倍,提供了更多的性能和机器学习(ML)加速。该芯片旨在满足ISO26262 ASIL-D的要求,旨在利用其对ML支持的汽车和机器人应用。SoC不仅可以用于自动驾驶汽车,还可以处理ADAS的杂务。

在CPU复合体中有十几个64位的“大力神”核,它与一个GPU结合在一起,该GPU包含一个CUDA张量核,能够交付200个INT8 TOPS。CPU核心是基于Arm的DynamIQ技术。此外,还有可编程视觉加速器(PVA)和英伟达的深度学习加速器(DLA)。内存子系统的带宽为200gb /s,有4个10gb /s以太网端口。

视频硬件可以以30帧/秒解码8K视频流,以60帧/秒编码4K视频流。这包括对H.264、H.265和VP9的支持。该芯片由台积电采用7纳米工艺制造。

英伟达还没有提供关于该芯片的所有细节,但它将提供3个TOPS/W。它的TDP可能是Jetson AGX Xavier的两倍。

DRIVE AGX Orin利用了英伟达基于cuda的深度神经网络(DNN) ML开发支持。这种支持允许应用程序在该公司的任何平台上运行,从紧凑的Jetson Nano到DRIVE平台,再到其基于云的系统。

除了DRIVE AGX Orin,英伟达在GTC中国展会上还发布了其他一些产品。一个是支持TensorFlow的TensorRT 7。TensorRT 7有一个新的编译器,可以自动优化ML模型以提高性能,有时提高了10倍。它的设计目的是将用于实时交互的模型的延迟降低到300毫秒以下,这通常是人机交互所需要的。

TensorRT 7支持循环神经网络(rnn),用于文本到语音等应用。它可以处理WaveRNN和Tacotron 2这样的模型。rnn还用于语音识别和语言翻译。

此外,新的编译器被优化以处理基于变压器的模型,如BERT(来自变压器的双向编码器表示)。BERT用于自然语言处理任务。

除此之外,英伟达正在向开发人员提供基于云计算的DRIVE Federated Server(图2).其想法是共享模型,而不是实际数据,为医疗领域等应用领域提供隐私。对于自动驾驶汽车模型来说,隐私也很重要。

客户-服务器模式让公司的软件在系统的两端运行。一个全局模型被分发给客户端,这些客户端增强了模型,并返回新的权重,以便将其合并到全局共享模型中。许多应用程序,如自动驾驶汽车,可以受益于更大的训练数据集。