图像处理是一项要求很高的任务,原因之一是它通常涉及到处理图像中的所有像素。在处理视频流时,必须处理多个帧。确定从一帧到另一帧的变化对于检测物体和其他变化是有用的,但它需要大量的马力和带宽来做到这一点。这种方法是必需的,因为图像捕获设备每次发送一帧。

但如果这不是获取图像信息的唯一方法呢?

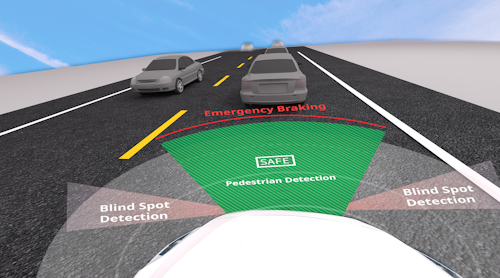

Prophesee的Metavision图像传感器(图1)采用了一种不同的方法——基于事件的传感器。将它对准一个纯色图像,它几乎不会生成任何数据,因为像素是不变的。在背景前面移动一只手,传感器就会开始发送一系列事件来指示像素发生了什么变化。这往往是像素总数的一小部分,这是大多数场景的典型情况。

该传感器实际工作在每个像素的可编程阈值上,允许系统具有超过120 dB的宽动态范围。这明显高于大多数图像传感器。因此,传感器即使在很宽的动态范围内也能检测到变化,这将导致传统传感器的问题。

例如,由于典型的图像传感器对每个像素的范围比较有限,因此眩光或弱光会造成问题。该传感器可以设置为低光情况,但如果场景中有明亮的光,它将提供一个最大的白色值。一个典型的颜色传感器可能有RGB值,尽管每像素只有8或16位。

图2强调了Metavision传感器将产生数据的领域。在这个案例中,视频是一个人挥舞高尔夫球杆。突出显示的区域是像素变化的地方。

这种传感器也有一个缺点,它不能显示每个像素的颜色,只能显示颜色的变化。如果需要这种类型的信息,应用程序可以将传统的图像传感器与Metavision传感器结合使用,但是Metavision传感器改变了应用程序分析视频的方式。它可能只对跟踪图像中的变化感兴趣。

例如,一个应用程序可能正在跟踪一个手势。一个人是否戴蓝色手套并不重要。该应用程序只是想识别手势,而Metavision传感器可以更经济地提供该信息。

框架和基于事件的

图3试图强调使用基于框架的成像系统和基于事件的系统之间的区别。假设有一个旋转的圆盘,圆盘周围有一个点。螺旋是蓝点位置随时间变化的映射。橙色和红色的点在特定的时间点突出蓝色的点的位置。右边的帧将是传统成像系统报告数据的方式,尽管我们只关心实际的点。圆圈和其他点是为了提供一个视角。

基于框架的系统会显示点从一个点跳到另一个点。一个足够高的帧率将揭示系统的旋转性质。本质上,我们有一个奈奎斯特抽样问题。

当然,一个足够快的基于帧的解决方案将为视频提供足够的信息进行分析。然而,这也意味着必须处理大量数据。如果要应用机器学习算法,则需要更强的处理能力。

尽管基于事件的系统可以很容易地跟踪旋转,但它提供的信息量会大大降低。事实上,一个微控制器可以很容易地处理来自这类成像系统的数据量与一个更复杂的场景和场景。当然,它可能会被大量变化的光线条件、反射等所淹没,但这在大多数情况下是不寻常的。

同样,许多应用程序有一个更受控制的环境,或者场景中的区域可以以某种方式分区或管理。Metavision传感器为每个像素设置的阈值也可以调整,从而允许忽略某些区域。

预言现在正在传递它的传感器。“这是预言的一个重要里程碑,凸显了我们开创性的基于事件的视觉传感技术的商业化进展。经过几年的测试和原型设计,我们现在可以为产品开发人员提供一种现成的方法,利用我们的机器视觉发明的优势,将行业从传统的基于框架的图像捕捉模式中解放出来。”

基于帧的视频处理仍然是一个有用的范例。然而,基于事件的视频处理开辟了一个全新的领域,可能会提供非常低端的平台,这些平台能够处理基于帧的输入流无法处理的图像处理杂事。

prophet提供的开发硬件和软件使开发人员能够立即实现Metavision传感器。目前的传感器有640-×-480的分辨率,在0.75英寸的屏幕上有15µm的像素大小。格式。它有一个0.04勒克斯低光截止和在1兆赫背景噪声活动。该传感器采用13 × 15毫米PBGA封装。