在第1部分在这个系列中,我们探索了世界数据的指数级增长,即每两年翻一番。有了这些数据,人类开始求助于人工智能(AI)来理解这些数据。处理能力和记忆能力必须继续提高,但新的挑战也在出现。

随着我们从数据中获得的见解变得越来越有价值,对更强安全性的需求也越来越大。不仅要保护数据,还要保护人工智能模型、训练数据和基础设施。不出所料,数据和见解的价值不断增长,正激励AI开发者开发更强大的算法、更有意义的数据集和更好的安全实践。

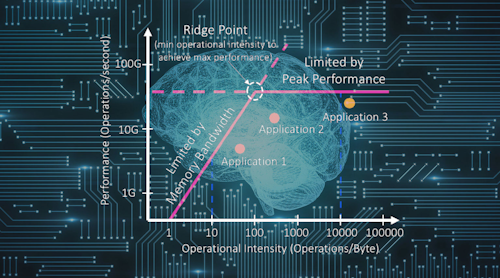

为了实现更好的算法和拓扑,以及处理不断增长的数据量,需要更快的处理器和内存。但是在过去的几十年里,半导体行业改善性能的两个主要工具——摩尔定律和登纳德比例法——已经不再像以前那样可靠了。摩尔定律正在放缓,Dennard Scaling在2005年左右崩溃了。为了继续满足尖端人工智能应用和数据指数增长的需求,该行业正被迫寻找新的方法来提高性能和电力效率。

与此同时,互联网的架构也在稳步发展。我们所熟悉的云处理模型(即端点捕获数据并将其传输到云进行处理)也在发生变化。随着5G的推出,将会有更多的连接设备和更多的数据,而将所有数据发送到地理上遥远的数据中心将是不可行的。

将处理移到边缘

随着世界数字数据的持续增长速度超过了网络的发展速度,新的处理机会将在边缘地带被发现。它的优势包括基站和位于云数据中心和端点之间的更多地理分布的处理位置。

边缘数据中心提供了更接近数据生成地点的处理能力,为自动驾驶汽车等应用程序提供了更低延迟的处理。通过在边缘处理数据,我们可以将少量的高价值数据发送到云数据中心,减轻对网络带宽的需求。通过这样做,我们将看到性能和电力效率的更大改进。

随着边缘处理成为主流,云仍将是我们数据经济的重要组成部分,并将继续用于最艰巨的任务。在某些情况下,端点捕获的数据在被发送到云数据中心之前将被发送到边缘进行初始处理。在其他时候,数据将直接进入云,在那里它可能与其他广泛地理位置上捕获的数据合并成一个聚合数据集。

艾未未的扩张作用

我们期望看到AI在不断发展的互联网中部署在数据中心、边缘,并越来越多地部署在终端,尽管每种需求和应用都将有所不同。最困难的任务,包括使用大型训练集的最大神经网络的训练和推理,将留在云数据中心。将使用性能最高的硬件解决方案,并将它们插入墙壁以获得最大的功率。

为了支持这些高性能的AI解决方案,需要高性能、最节能的内存解决方案。片上存储器和非常高性能的离散DRAM解决方案(如HBM和GDDR)都将在这个空间中使用。终端设备将主要保持电池供电,并继续用于推理,就像我们今天看到的一样。终端设备的存储系统通常使用片上存储器或低功耗移动存储器。

今天,边缘的定义得到了扩展,现在包括近边缘(更接近数据中心核心)和远边缘(更接近端点)。在未来,我们将看到在边界上使用的所有内存解决方案。

在接近边缘的情况下,处理器和内存系统将类似于我们在云中看到的那些,使用片上内存、HBM和GDDR。当我们向端点迁移时,远端边缘的处理器和内存将与我们在端点中看到的类似,包括片上内存、LPDDR和DDR。但我们也希望看到一些终端应用程序需要极高的性能,比如自动驾驶汽车。对于这些设备中的AI,像GDDR这样的内存适合满足性能和能效需求。

人工智能的复兴彻底改变了世界存储、分析和交流数据的方式。人工智能和数字数据之间形成了一种有趣的关系。需要大量数据才能让AI变得更好,而在许多情况下,AI是理解大量数据的唯一合理方式。展望未来,如果人工智能应用程序要继续实现其全部潜力,那么高带宽、节能的内存就必须处于前沿。我们将在第3部分进一步探讨这个问题。